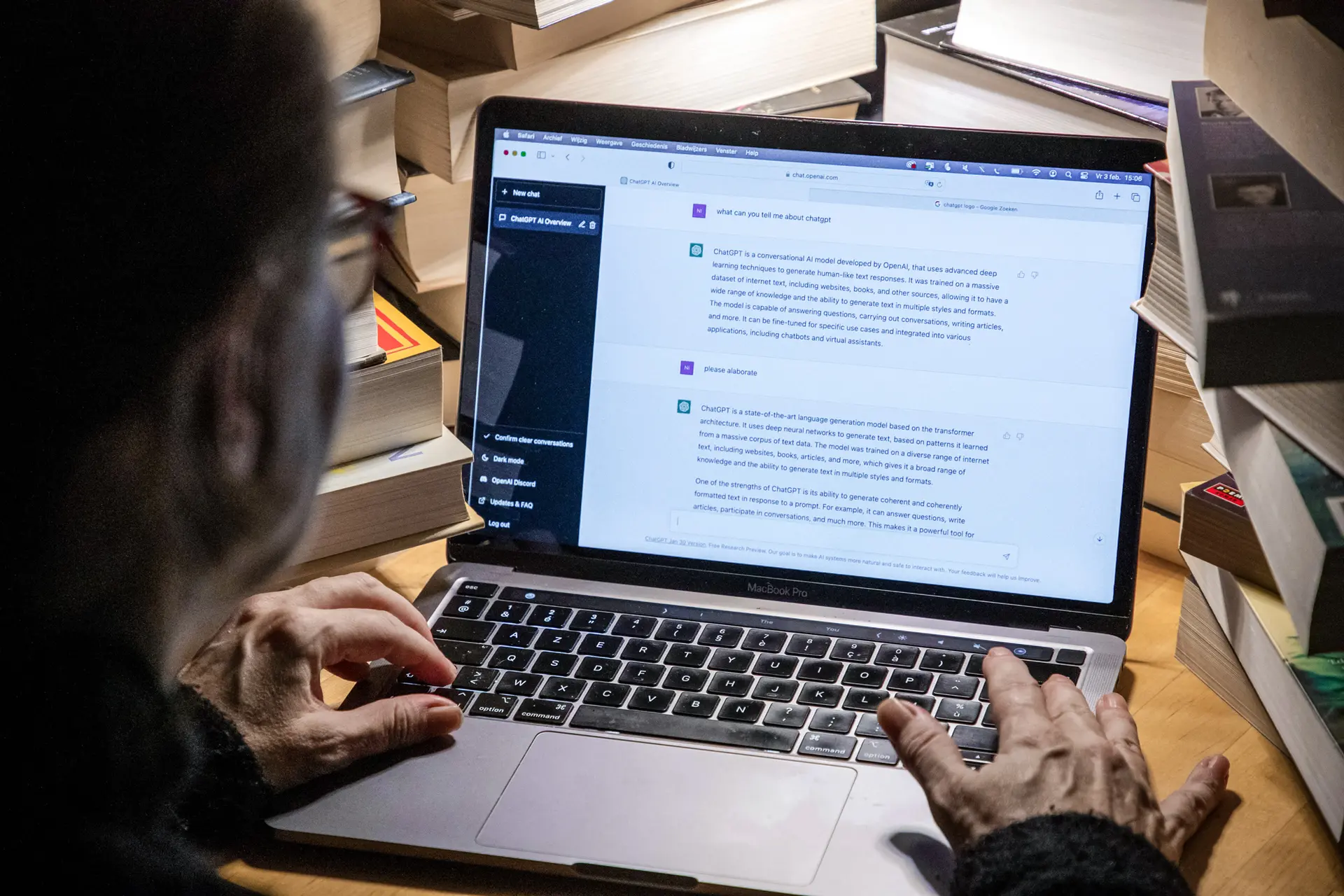

ATLANTA.— El periodista Fred Riehl accedió a ChatGPT el 4 de mayo de 2023 para investigar la demanda interpuesta por la Second Amendment Foundation (SAF, Fundación de la Segunda Enmienda) contra el fiscal general del estado de Washington.

El sistema le ofreció una historia explosiva.

Según ChatGPT, el conocido presentador de pódcast de la SAF, Mark Walters, había sido acusado de «defraudar y malversar fondos de la SAF».

ChatGPT sostuvo que, como tesorero y director financiero de la fundación, Walters «se apropió indebidamente de fondos para gastos personales sin autorización ni reembolso, manipuló registros financieros y extractos bancarios para ocultar sus actividades y no proporcionó informes financieros precisos y oportunos a la dirección de la SAF».

Era el tipo de exclusiva que persigue cualquier periodista. Pero era falsa de principio a fin.

La inteligencia artificial (IA) está transformando numerosos ámbitos de la sociedad estadounidense. Los ámbitos jurídico, del entretenimiento, sanitario y mediático afrontan nuevos dilemas éticos y morales.

¿Cuánta confianza debemos depositar en las máquinas para obtener información veraz? ¿Quién se hace responsable cuando la tecnología falla?

Un creador en YouTube, un autor de pódcast o un bloguero promedio quizá no entienda cómo la misma tecnología que les ayuda a producir contenido puede, a la vez, difundir información falsa sobre ellos y dificultar su defensa.

Walters afirma haber asumido esa amarga realidad.

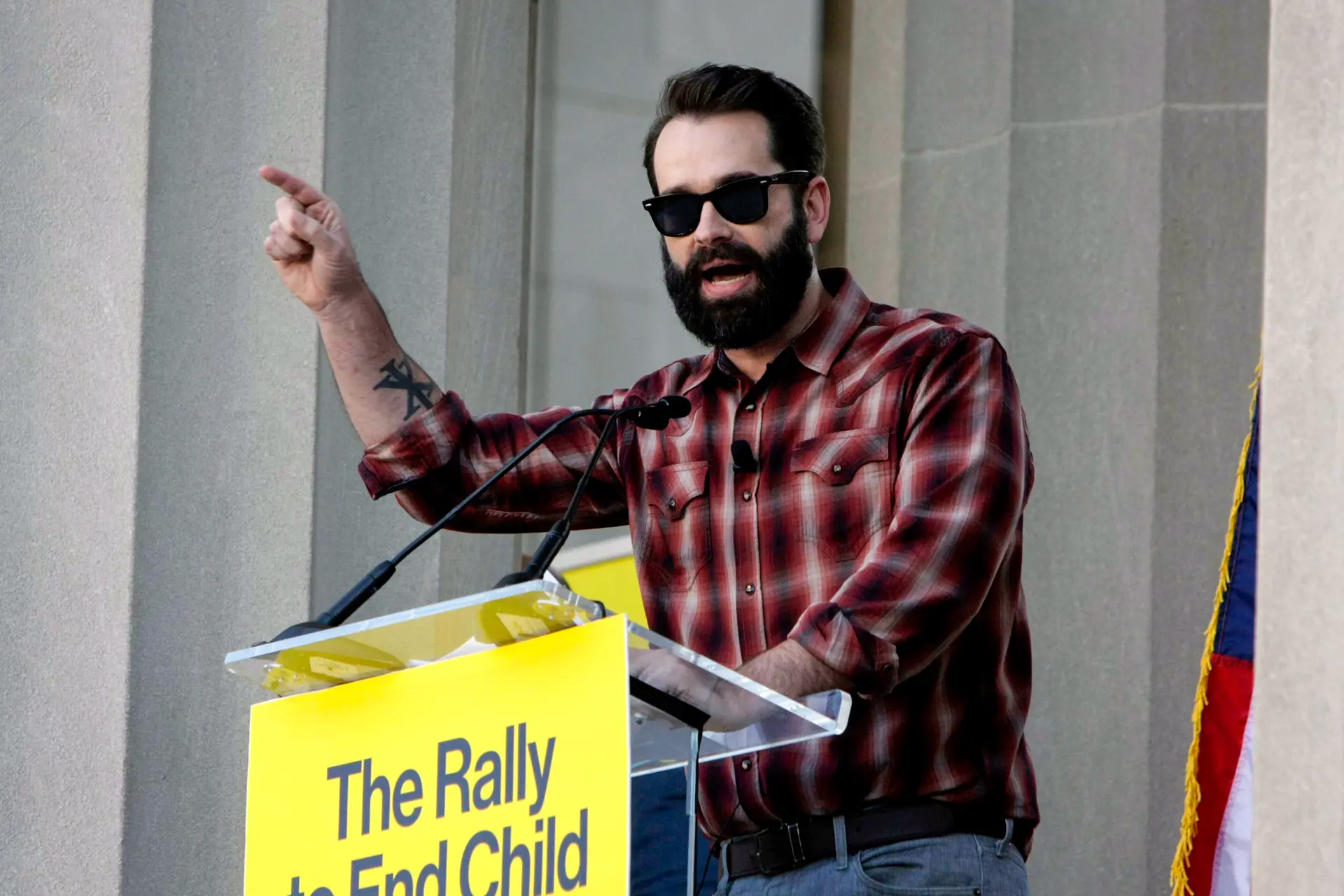

Walters es el presentador del pódcast «Armed American Radio». Presentó y perdió la primera demanda por difamación basada en información generada por inteligencia artificial. Le sorprendió comprobar que la ley valoró más su condición profesional que la veracidad de los hechos.

«Hoy en día la pregunta es: ¿quién es una figura pública? Usaron esa carta en mi contra y les salió bien», declaró Walters a The Epoch Times.

Riehl escribía sobre temas relacionados con la Segunda Enmienda en internet y conocía tanto a Walters como a Alan Gottlieb, vicepresidente ejecutivo de la SAF.

Aunque Walters forma parte de la junta directiva del Comité Ciudadano por el Derecho a Portar Armas, afiliado a la SAF, no tenía relación alguna con la demanda en el estado de Washington.

Según consta en el expediente judicial, Riehl solicitó varias veces información al sistema sobre la demanda de la SAF. ChatGPT respondió que no podía atender su petición.

Por ello, Riehl le proporcionó un enlace a la demanda y pidió a ChatGPT que resumiera el caso.

La respuesta del sistema lo dejó atónito. Riehl llamó a Gottlieb, quien le confirmó que las acusaciones eran falsas. Gottlieb, a su vez, contactó con Walters.

«Recuerdo que era mi cumpleaños, el 5 de mayo. Fue temprano; Alan Gottlieb me llamó y me dijo: “¿Estás sentado?”», relató Walters.

Walters quedó estupefacto. El sistema no solo le proporcionó información, sino que generó documentos que una persona ajena al ámbito judicial podría tomar por auténticos.

«El documento decía “Alan Gottlieb, SAF, contra Mark Walters”, con un número de expediente y un número de caso falsos. A cualquiera que no haya visto nunca un documento judicial u oficial —incluso a quien sí— podría parecerle auténtico. Por eso Fred llamó a Alan», explicó.

ChatGPT afirmó que la supuesta demanda se presentó en el Tribunal de Distrito de Estados Unidos para el Distrito Oeste de Washington, en Seattle. Una búsqueda en los registros de ese tribunal no arrojó resultados en los que Walters figurara como parte.

Riehl no respondió a los correos electrónicos con solicitudes de comentario para este artículo. Tampoco OpenAI, propietaria de ChatGPT.

Los abogados de OpenAI indicaron ante el tribunal que ChatGPT había tenido una «alucinación».

ChatGPT aprende

Kirk Sigmon es abogado en Washington D. C., especializado en propiedad intelectual, ingeniería informática y patentes de ingeniería eléctrica. Cuenta con experiencia en modelado de lenguaje a gran escala, el proceso que utiliza ChatGPT para aprender.

Sigmon señaló que no está claro cómo aprende exactamente ChatGPT, porque esos detalles son confidenciales de OpenAI. No obstante, dijo, sí se conocen algunos principios generales.

Una idea errónea habitual es considerar la IA un motor de búsqueda avanzado que entrega datos a demanda, como una enciclopedia digital.

«Si un buscador se asemeja a una enciclopedia, la IA se parece más a un estudiante de posgrado: ofrece información y, al mismo tiempo, aprende sobre la marcha», explicó. «Y, como cualquier estudiante, a veces se equivoca». Añadió que el sistema está diseñado para obtener información de cualquier fuente disponible, incluidas las propias solicitudes de los usuarios.

Debería ser ilegal. No deberían usar mi imagen ni mi voz sin mi consentimiento. (Matt Walsh, comentarista político conservador)

«Estos modelos, al estar entrenados para aprender, pero no para memorizar, son inherentemente imperfectos», afirmó.

Un episodio reciente entre un conocido podcaster y su réplica de IA ilustra ese proceso de aprendizaje.

Durante un episodio de su pódcast emitido el 25 de octubre, el comentarista político conservador Matt Walsh interactuó con un chatbot entrenado para imitar su voz y estilo. Walsh afirmó que la experiencia fue inquietante.

«Esto no está bien; nada de esto está bien. Esto no debería ser legal», declaró durante el pódcast.

Durante la conversación, la IA afirmó que Walsh tiene una hijastra de 17 años llamada Sofía.

Cuando Walsh señaló al bot que esa información era errónea, este replicó: «Entonces, dime los nombres de tus seis hijos».

La IA «Walsh» también expresó su apoyo al matrimonio entre personas del mismo sexo y a la transexualidad, dos posturas a las que el verdadero Walsh se opone. Walsh fue clave en la reforma de la ley estatal de Tennessee que prohíbe los procedimientos médicos de transición de género en menores.

Walsh abogó por prohibir el uso de la IA para imitar a personas reales.

«Debería ser ilegal. No deberían usar mi imagen ni mi voz sin mi consentimiento», indicó.

«Debería poder interponer una demanda para poner fin a esto».

Según la ley vigente, Walsh puede interponer una demandar, pero se enfrentaría al mismo obstáculo que Walters.

Primero, Riehl no dio crédito a la información y llamó a Gottlieb. Además, Walters admitió que no había sufrido un daño real porque solo Riehl, Gottlieb y él vieron el contenido, y los tres sabían que era falso.

Las figuras públicas deben acreditar en su demanda que la información falsa no solo lesionó su reputación, sino que el editor no actuó con la diligencia debida para verificarla.

El principal escollo para Walters fue su condición de figura pública en un ámbito concreto.

En la mayoría de los estados, el umbral para que un particular prospere en un caso de difamación es relativamente bajo: basta con que una afirmación lo exponga al ridículo público o dañe su reputación.

En cambio, para las figuras públicas el listón es más alto: quien demanda debe probar el perjuicio reputacional y la falta de diligencia del editor al garantizar la veracidad de lo publicado.

Walters habría tenido que demostrar que OpenAI actuó con desprecio temerario por la verdad.

Los abogados de OpenAI señalaron —y el tribunal lo aceptó— que el funcionamiento de ChatGPT incluye múltiples advertencias de que la información que ofrece puede ser incorrecta o incluso falsa.

A un ordenador no le importa si la información es falsa, especialmente si se ajusta al patrón del algoritmo. Sigmon afirmó que, si la primera respuesta resulta incorrecta, la IA simplemente recalcula.

Cree que eso fue lo que ocurrió cuando Riehl consultó a ChatGPT sobre la demanda: el sistema no disponía de la información necesaria. Por ello, Riehl reformuló su petición y el sistema recalculó hasta producir una respuesta que parecía coherente.

Matthew B. Harrison, vicepresidente de Talkers Magazine —revista especializada en radio informativa y de entrevistas—, opinó que el caso de Walters concluyó prematuramente. Añadió que persisten cuestiones legales y éticas, más allá de su condición de figura pública, que siguen sin resolverse.

Cuestiones de derechos de autor

Harrison señaló que buena parte de los datos con los que aprende la IA está protegida por derechos de autor.

Si Walters hubiera ganado, la siguiente pregunta lógica sería: ¿quién responde legalmente? El sistema procesa un caudal ingente de datos. Atribuir la responsabilidad a una sola fuente de la información falsa, ya sea por infracción de derechos de autor o por difamación, resulta irreal.

«Identificar la fuente y, por lo tanto, poder afirmar que la empresa la robó, la usó indebidamente o lo que sea, es una tarea imposible», manifestó Walters.

Explicó que decidió no recurrir la decisión judicial porque no dispone de recursos para una batalla legal prolongada. Aun así, sostuvo que su caso ha sacado a la luz un problema que debe abordarse.

Añadió que le sigue irritando que la historia falsa se califique como una «alucinación» de la IA.

Walters propone una expresión más directa, comprensible de inmediato: «Mintieron sobre mí».

«Como saben, a esas mentiras las llaman “alucinaciones”; hasta les han puesto nombre. Saben que ocurre. Y, en palabras de mi abogado: “Han puesto este robot en el mundo sabiendo que hace esto, y eso está mal”».

Artículo publicado originalmente en The Epoch Times con el título «He Was the First to Sue AI for Defamation–the Result Is a Cautionary Tale»

Cómo puede ayudarnos a seguir informando

¿Por qué necesitamos su ayuda para financiar nuestra cobertura informativa en España y en todo el mundo? Porque somos una organización de noticias independiente, libre de la influencia de cualquier gobierno, corporación o partido político. Desde el día que empezamos, hemos enfrentado presiones para silenciarnos, sobre todo del Partido Comunista Chino. Pero no nos doblegaremos. Dependemos de su generosa contribución para seguir ejerciendo un periodismo tradicional. Juntos, podemos seguir difundiendo la verdad.